Crawling dan indexing – merupakan dua pekerjaan utama Google bot. Webmaster bisa menangani indexing website mereka dengan membuat beberapa modifikasi terlebih dahulu. Hal ini membuat bot melakukan tugasnya secara teliti dan memberikan kesempatan bagi website tersebut agar ter-ranking lebih baik.

Lima langkah berikut membantu Anda mengoptimasi crawling website Anda dan terindeks agar website Anda lebih mudah ditemukan di Web.

Daftar Isi

1. Fundamental Dasar Dari Crawling dan Indexing

-

The Robots.txt

Robots.txt merupakan file sederhana yang memberi instruksi tertentu kepada Google bot mengenai bagaimana sebuah website harus di-crawl. Contohnya, pengecualian untuk direktori tertentu. Ini seringkali disebut area data-sensitive, seperti login dan akun customer, yang seharusnya tidak terindeks.

Ketika membuat file robots.txt, Anda harus memastikan bahwa bot memiliki akses ke semua resource yang dibutuhkan untuk menampilkan website Anda dengan benar. Misalnya, Anda tidak bisa memblock file CSS atau JavaScript di robots.txt.

Jika Anda ingin mengeluarkan direktori tertentu dari crawl, gunakan code robots.txt berikut:

User-agent: *

Disallow: /directory/*

Tanda bintang (*) merupakan placeholder (atau disebut wildcard) dan mewakili semua konten lainnya yang berhubungan dengan direktori tersebut.

Setelah membuat file robots.txt, Anda perlu menyimpannya di root directory website.:

www.mywebsite.com/robots/txt

Tip

Gunakan Google Search Console untuk mengetes robots.txt Anda. Tolong diingat Anda perlu mendaftarkan website ke Search Console terlebih dulu.

-

XML Sitemap

Selain robots.txt, ada file lainnya yang memegang peranan penting dalam indexing: XML sitemap. File ini dapat membaca mesin dengan mendaftar semua URL yang ada dalam website Anda. Data yang tersusun ini dibuat dalam bentuk teks dan disimpan dalam format XML. File ini juga bisa mengirimkan informasi lain selain URL, seperti kapan terakhir kali URL diupdate.

Setelah Anda membuat file XML, tambahkan dalam Google Search Console untuk memberitahu URL yang ada kepada Google. Namun, XML sitemap hanya merekomendasikan URL kepada Google dan tidak memberi instruksi apapun kepada bot seperti yang dilakukan oleh file robots.txt. Karena itu, Google akan mengabaikan konten file ketika mengindeks website.

Seringkali XML sitemap dijalankan secara buruk meskipun nyatanya sangat berguna dalam melakukan indexing website yang baru dan besar karena file menginformasikan Google mengenai semua sub-pages yang ada.

Susunan dari XML sitemap yang simpel tanpa tambahan atribut terlihat seperti ini:

Ada banyak cara untuk membuat sebuah sitemap. Beberapa CMS bahkan menggunakan tools untuk secara otomatis membuat sebuah sitemap. Anda juga bisa menggunakan program gratis apapun yang tersedia secara online.

Setelah sitemap siap, simpan dalam root directory website Anda:

www.mywebsite.com/sitemap.xml

Compress sitemap atau simpan agar tidak memenuhi space di server.

Google merekomendasikan agar membagi sitemap jika Anda punya lebih dari 50,000 URL. Dalam hal ini, Anda perlu menggunakan index dan membuat sebuah “sitemap of the sitemap”. Index sitemap harus berisi semua link yang mengarah ke XML sitemap yang berbeda. Kurang lebih terlihat sepert ini:

Kemudian Anda upload file ke dalam Search Console untuk mengaktifkan Google meng-crawl ulang sub pages.

Jika Anda punya banyak video dan gambar di website, Anda harus memeriksa indexing untuk universal search dengan membuat sitemap terpisah untuk gambar dan video. Struktur dari XML sitemap untuk file media mirip dengan sitemap yang biasa.

Tip

Dalam banyak kasus, Anda ingin website Anda di re-crawl secepat mungkin setelah Anda membuat beberapa modifikasi. Google Search Console membantu dalam banyak hal. Masukkan website yang berhubungan dan segera kirimkan ke Google index. Fungsi ini terbatas untuk 500 URL per bulan untuk setiap website.

2. Gunakan Budget Crawl

Google bot merupakan program computer yang dirancang untuk follow link, crawl URL, dan kemudian diartikan, dikelompokkan, dan mengindeks kontennya. Untuk melakukan ini, bot memiliki crawl budget terbatas. Jumlah pages yang di crawl dan index bergantung pada page rank dari website yang bersangkutan, begitu pula seberapa mudah bot bisa follow link di website.

Website yang teroptimasi secara terstruktur akan memudahkan bot. Khususnya, flat hierarchies membantu meyakinkan bot mengakses semua webpages yang tersedia. Sebagaimana user tidak suka jika harus mengklik lebih dari empat kali untuk mengakses konten yang dituju, Google bot seringkali tidak bisa masuk ke data yang luas dan dalam jika jalannya sangat rumit.

Crawling juga bisa dipengaruhi oleh penggunaan internal link Anda. terlepas dari menu navigasi, Anda bisa memberikan bot dengan hint pada URL yang lain dengan menggunakan deep link dalam teks. Dengan cara ini, link yang mengarah ke konten penting dari homepage Anda akan di crawling lebih cepat. Penggunaan anchor tags untuk menjelaskan target link akan memberi informasi tambahan kepada bot mengenai apa yang diharapkan dari link dan bagaimana mengklasifikasi konten tersebut.

Agar bot bisa meng-crawl konten Anda lebih cepat, jabarkan heading Anda menggunakan h-tags. Di sini Anda harus menstruktur tags secara berurutan. Artinya Anda menggunakan h1 tag untuk main title dan h2, h3, dll untuk subheadings.

Banyak CMS dan web designer yang sering menggunakan h-tags untuk memformat ukuran page heading mereka karena lebih mudah. Hal ini bisa membingungkan Google bot saat proses crawling. Anda harus menggunakan CSS untuk menentukan ukuran font untuk konten.

3. Jangan Memaksa Bot Untuk Melakukan Detour

Orphan pages dan 404 errors menguras crawl budget yang tidak seharusnya.

Setiap Google bot menemukan error page, dia tidak bisa mengikuti link lainnya dan harus kembali dan memulai lagi dari point yang berbeda. Browsers atau crawlers seringkali tidak bisa menemukan URL setelah operator website menghapus produk dari online shop mereka atau setelah mengubah URL mereka. Dalam beberapa kasus, server mengembalikan 404 error code (not found). Namun, angka yang tinggi untuk sejumlah error menghabiskan sebagian besar dari crawl budget bot. Webmaster harus memastikan mereka memperbaiki error setiap harinya (juga lihat #5 – “Monitoring”)

Orphan pages merupakan pages yang tidak memililki internal inbound link apapun tapi mungkin punya external links. Bot-nya tidak bisa melakukan crawl pada beberapa pages atau dipaksa menghentikan crawling. Serupa dengan 404 errors, Anda juga harus menghindari orphan pages. Pages ini seringkali dihasilkan dari error dalam desain web atau jika syntax dari internal links salah.

4. Hindari Duplicate Content

Menurut Google, duplicate content tidak berpengaruh dengan website yang bersangkutan. Namun, bukan berarti duplicate content tetap ada dalam website. Jika SEO atau webmaster membiarkannya, search engine akan menentukan konten mana yang di index dan URL mana yang diabaikan berdasarkan tingkat kemiripan yang tinggi. Perhatikan dan kendalikan bagaimana Google menangani konten dengan menggunakan tiga pengukuran berikut:

- 301 redirects: Duplicate content bisa terjadi sangat cepat, terutama jika versi dengan www. dan tanpa www. terindeks. Hal yang sama juga berlaku untuk koneksi secure via https. Untuk menghindari duplicate content, Anda harus menggunakan redirect (301) permanen yang mengarah ke webpage versi yang diinginkan. Usaha ini perlu memodifikasi file .htaccess Anda atau menambahkan preferred version dalam Google Search Console.

- Canonical tag: Khususnya, online shop beresiko meningkatkan duplicate content dengan mudah karena sebuah produk dapat ditemukan pada berbagai URL. Solusinya dengan menggunakan canonical tag. Tag ini memberitahu Google bot tentang URL asli yang harus di indeks. Anda harus memastikan bahwa semua URL yang seharusnya tidak terindeks memiliki tag yang mengarah ke canonical URL dalam source code Anda. Ada beberapa tools yang bisa digunakan untuk mengetas canonical tags Anda. Tools ini membantu Anda mengidentifikasi pages yang tidak memiliki canonical tag atau memiliki canonical tag yang salah. Idealnya, setiap page harus mempunyai canonical tag. Pages original/unik harus punya self-referencing canonical tags.

- rel=alternate: Tag ini akan sangat berguna jika sebuah website tersedia dalam berbagai bahasa atau jika Anda punya website versi mobile dan desktop. Tag ini memberitahu Google bot entang alternative URL dengan konten yang sama.

5. Monitoring: Perbaikan

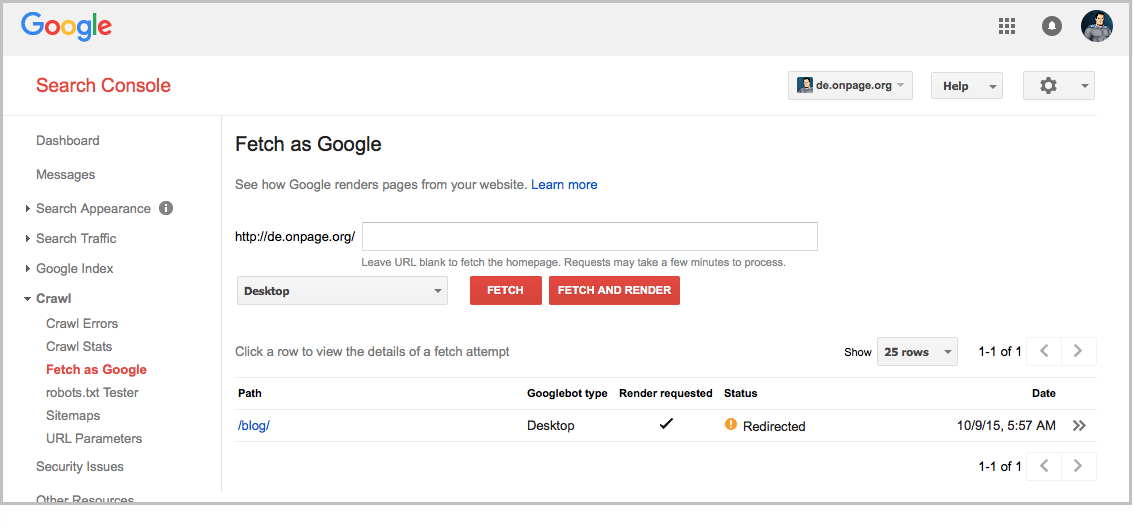

Memeriksa data dalam Google Search Console secara teratur merupakan cara yang bagus untuk mengetahui bagaimana Google melakukan crawl dan index website Anda. Search Console menyediakan banyak tips yang membantu Anda mengoptimasi bagaimana website Anda di crawl.

Dibawah “crawl errors”, Anda akan menemukan list lengkap yang terdiri dari 404 errors dan yang disebut dengan “soft 404 errors”. Soft 404 errors menggambarkan pages yang tidak ditampilkan secara benar dan server mana yang tidak mengembalikan error code.

Di sini, statistic crawl ditampilkan sangat jelas. Data tersebut menunjukkan seberapa sering Google bot mengunjungi website dan juga berapa jumlah data yang di download selama proses tersebut. Penurunan value yang terjadi secara tiba-tiba mungkin sebuah indikasi terjadinya error di sebuah website.

Selain “Fetch as Google” dan “robots.txt Tester”, tools “URL parameter” bisa menjadi sangat berguna. Dalam hal ini webmaster dan pelaku SEO bisa menentukan bagaimana Google bot harus menangani parameter URL tertentu. Contohnya, menentukan signifikansi dari parameter tertentu untuk menginterpretasi URL membantu Anda mengoptimasi lebih jauh crawl budget dari Google bot.

Kesimpulan

Pilihan yang dijelaskan dalam artikel ini akan membantu Anda mengoptimasi bagaimana Google bot melakukan crawling dan indexing pada website Anda. Hasilnya, usaha di atas membuat website Anda semakin mudah ditemukan di Google. Oleh karena itu, pilihan di atas menentukan dasar keberhasilan sebuah website, jadi tidak ada cara lain agar mendapat ranking yang lebih baik.

Sumber: Search Engine Journal

makasih gan untuk sarannya…

ditunggu tulisan lainnya..

terimakasih gan artikelnya bagus, cuma saya belum paham gan. bisa dijelaskan lebih rinci nya ga gan ? tks

Sangat membantu untuk pemula seperti saya. Terimakasih ya info nya

Terima Kasih Refrensinya. Sangat Bermanfaat

Sangat bagus infonya gan, saat ini saya sedang belajar untuk melakukan SEO sendiri. Mohon pencerahannya gan, yaitu bagaimana caranya menggunakan Google Console yang benar. Terimakasih.

terima kasih gan, sudah berbagi, sangat membantu informasi nya

Thank mbak atas informasinya.

Bermanfaat sekali.

bagus banget gan artikelnya

tips yg bagus, jadi lebih pintar nih tentang topik SEO dan digital marketing

saat ini saya sedang belajar untuk melakukan SEO sendiri di blog saya, namun masih bingung pada masalah tag di template blog saya, ada yang sudi membantu saya

good luck mba..

terimakasih untuk informasinya. Saat ini saya sedang beljar SEO di blog saya. sungguh menginspirasi

Thanks banget infonya gan

Mantap ilmunya bermanfaat. makasih byk ya.

Sangat bermanfaat sekali ini artikel. Menaikan sebuah Kw memang butuh kesabaran.

membantu sekali mas,, makasih, nih

Terima kasih mas, infonya sangat bermanfaat bagi kalangan blogger pemula seperti kami.

baru tau info yang ini, thx gan

saat ini saya sedang belajar untuk melakukan optimasi SEO pada website toko online saya, tetapi sayamasih bingung dengan cara nya. dan terimakasih atas infonya..

Untuk artikel dengan jumlah 250an berapa lama proses agar semua artikel dapat terindeks ?

informasinya sangat bermanfaat pak

informasi data di artikel ini sangat bermanfaat. terima kasih

website ini sangat bermanfaat dan memberikan pengetahuan. terima kasih

terima kasih informasi nya